인공지능

[인공지능] - Accuracy, Precision, Recall, F1-Score

파커초

2024. 2. 7. 21:29

Accuracy

- 정확도는 말 그대로 얼마나 정확하냐를 측정하는 지표, 예를들어 개와 고양이를 분류하는 모델에서 전체 (개 5장, 고양이 5장) 10장중 9장을 올바르게 분류하고 1장을 다르게 분류했다면 해당 모델의 정확도는 90%가 됨. 이를 보다 정확하게 표현하면 아래와 같음

- correct predictions / total predictions

- 하지만 정확도는 데이터가 불균형할때는 좋지않은 방법임 (개 99마리, 고양이 1마리) 인 경우 정확도가 99퍼센트여도 고양이가 틀려버리면 해당 모델은 좋은 성능의 모델이 아니기 때문에

Solving imbalanced data through metrics

- 데이터 불균형 문제를 해결하는 하나의 방법 = F1 Score 사용

- 예측 오류 개수만 관련되는 것이 아닌 발생한 오류의 종류도 관여하게 됨

Precision and Recall: foundations of the F1 Score

- 정밀도와 재현율은 데이터가 불균형할때 사용하는 가장 대표적인 2가지 메트릭 F1 Score 의 기초가 됨.

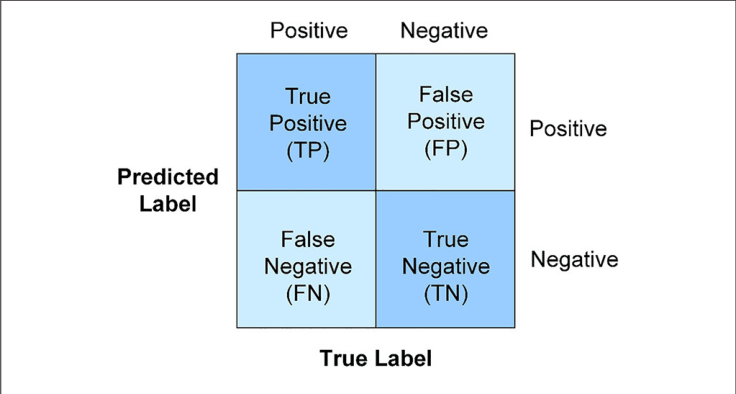

- Precision = True Positive / (True Positive + False Positive)

- 양성이라고 판정한것중에서 실제 양성의 개수

- negative 인것을 positive 로 예측한 노이즈가 많이 껴있음

- 정확한 모델은 pure 함, 모델 양성은 찾지는 못하더라도 최소한 positive라고 예측한것은 모두 positive

- 문제가 없는 제품을 있는 제품이라고 되돌려주는 것은 상관없지만

- 문제가 있는 제품을 없는 제품이라고 하는것은 문제가 될 수 있음

- Recall = True Positive / (True Positive + False Negative)

- 실제 True 인것중에서 모델이 True 라고 예측한 것의 비율

- Recall 이 높으면 몇개의 negative를 positive라 분류할지라도 data에서 positive case 를 잘 찾은 것을 의미함

- Recall 이 낮으면 데이터에서 positive case 를 전혀 찾을 수 없다는 것

F1 Score: combining Precision and Recall

- Precision 과 Recall 로 F1 score 가 구성되고 불균형한 데이터에서 잘 동작하는 평가지표가 됨

- F1 score 는 precision과 recall 의 조화평균이 되고 공식은 아래와 같음

- 조화 평균인 이유는 정확도가 작은 값에 영향을 더 많이 받기 위해